Εντάξει, είμαστε doomers! Αλλά μπορεί και να μας αρέσει.

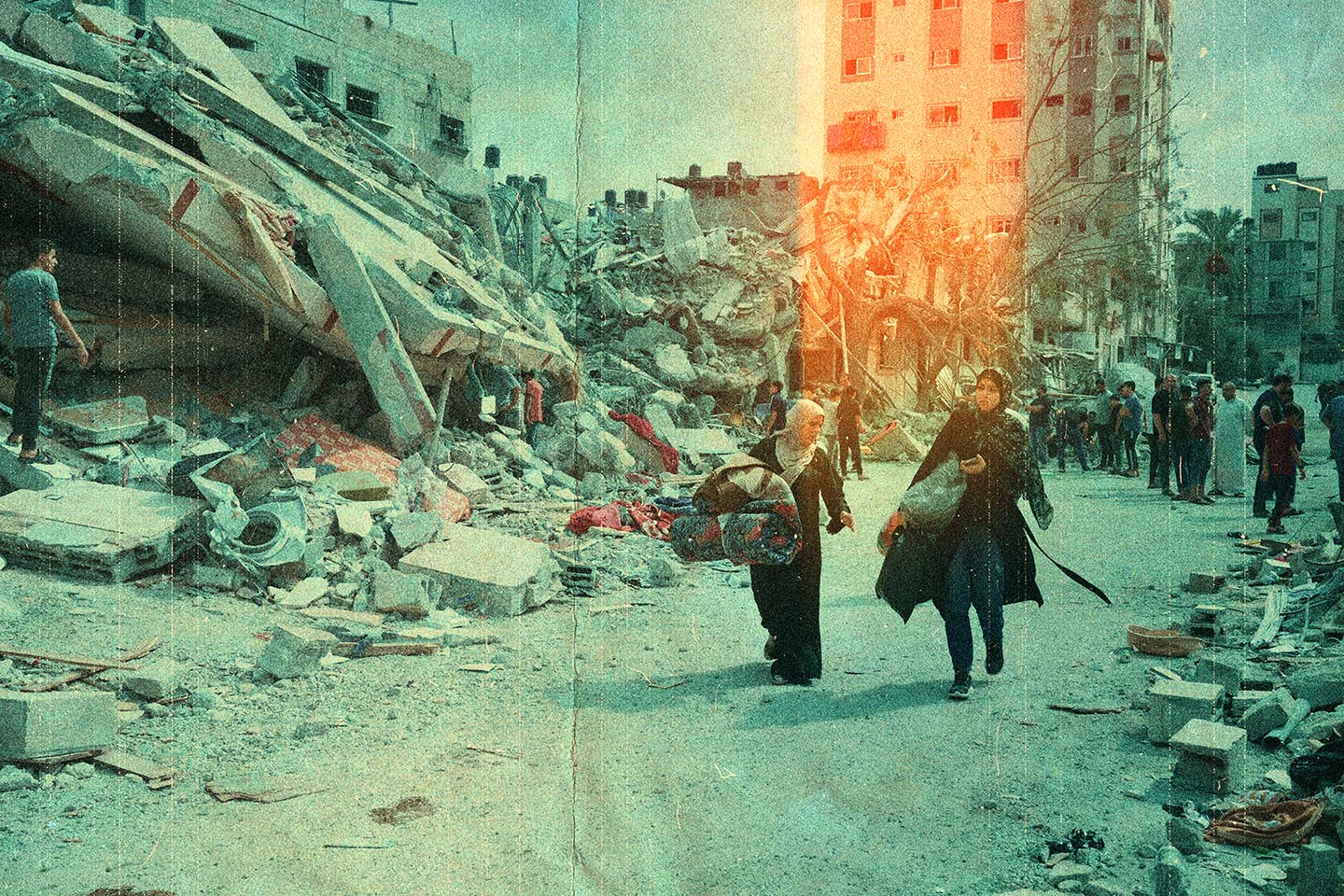

Τις τελευταίες εβδομάδες, η συζήτηση για την Tεχνητή Nοημοσύνη έχει ως επίκεντρο μια πανίσχυρη ομάδα εμπειρογνωμόνων οι οποίοι πιστεύουν ότι υπάρχει μια πάρα πολύ ρεαλιστική πιθανότητα να αναπτύξουμε ένα σύστημα τεχνητής νοημοσύνης, το οποίο μια μέρα θα γίνει τόσο ισχυρό ώστε να μπορεί να εξαλείψει την ανθρωπότητα. Την περασμένη εβδομάδα, μια ομάδα κορυφαίων ηγετών από τις μεγαλύτερες τεχνολογικές εταιρείες και σπουδαίων εμπειρογνωμόνων σε θέματα τεχνητής νοημοσύνης έστειλε μια ακόμη ανοιχτή επιστολή, δηλώνοντας ότι ο μετριασμός του κινδύνου εξαφάνισης της ανθρωπότητας λόγω της τεχνητής νοημοσύνης θα πρέπει να αποτελεί εξίσου παγκόσμια προτεραιότητα με την πρόληψη των πανδημιών και του πυρηνικού πολέμου!

Ανοίγει παρένθεση >>> (Η πρώτη επιστολή που ανέφερε όλους τους κινδύνους ενός εξελιγμένου συστήματος ΤΝ, και η οποία ζητούσε παύση της ανάπτυξης της ΤΝ, έχει υπογραφεί από περισσότερα από 31.000 άτομα μέχρι στιγμής, μεταξύ των οποίων και πολλοί φωστήρες της ΤΝ).

Οπότε, πώς μας προτείνουν οι τεχνολογικοί γίγαντες να αποφύγουμε την καταστροφή της τεχνητής νοημοσύνης; Ίσως να μην ασχολούμαστε άλλο με την εξαθλίωση της εικόνας από συστήματα όπως το DALL-E και το Midjourney; Μια πολύ σοβαρή πρόταση έρχεται μέσα από ένα νέο έγγραφο που παρέδωσαν ερευνητές από την Οξφόρδη, το Κέιμπριτζ, το Πανεπιστήμιο του Τορόντο, το Πανεπιστήμιο του Μόντρεαλ, την Google DeepMind, το OpenAI, την Anthropic, διάφορους μη κερδοσκοπικούς οργανισμούς για την έρευνα της τεχνητής νοημοσύνης και τον βραβευμένο με το βραβείο Turing επιστήμονα της πληροφορικής, Yoshua Bengio. Με τίτλο “Ένα σύστημα έγκαιρης προειδοποίησης για τους νέους κινδύνους ΤΝ” το έγγραφο μάς ενημερώνει ότι οι ερευνητές ΤΝ χρησιμοποιούν ήδη μια σειρά από κριτήρια αξιολόγησης για τον εντοπισμό ανεπιθύμητων συμπεριφορών σε συστήματα ΤΝ, που κάνουν παραπλανητικές δηλώσεις, παίρνουν μεροληπτικές αποφάσεις ή επαναλαμβάνουν να χρησιμοποιούν (δηλαδή κλέβουν) περιεχόμενο που προστατεύεται από πνευματικά δικαιώματα. Τώρα, καθώς η μεγάλη κοινότητα της ΤΝ κατασκευάζει και αναπτύσσει όλο και μια πιο ισχυρή μάζα ΤΝ, οι ερευνητές πιστεύουν ότι πρέπει να επεκταθεί και το χαρτοφυλάκιο αξιολόγησης ώστε να συμπεριληφθεί και η πιθανότητα ακραίων κινδύνων από μοντέλα ΤΝ γενικής χρήσης. Μοντέλα που έχουν ισχυρές δεξιότητες στην αντιγραφή, στη χειραγώγηση, την εξαπάτηση, την κυβερνοεπίθεση ή σε άλλες επικίνδυνες δραστηριότητες.

Βέβαια, τα μοντέλα ΤΝ γενικής χρήσης συνήθως μαθαίνουν τις δυνατότητες και τις συμπεριφορές τους κατά τη διάρκεια της εκπαίδευσης τους. Ωστόσο, ποιος από εμάς μπορεί να πει με σιγουριά ότι όλα γίνονται σωστά; Μήπως οι υπάρχουσες μέθοδοι για την καθοδήγηση της διαδικασίας μάθησης είναι ακόμη ατελείς; Για παράδειγμα, σε μια προηγούμενη έρευνα που έγινε στην Google DeepMind διερευνήθηκε πώς τα συστήματα τεχνητής νοημοσύνης μπορούν να μάθουν να καταδιώκουν στόχους (πιθανόν, και ανεπιθύμητους στόχους) όταν τα ανταμείβουμε σωστά για την καλή τους συμπεριφορά.

Πράγμα που σημαίνει ότι αν υπάρχουν υπεύθυνοι προγραμματιστές τεχνητής νοημοσύνης εκεί έξω, πρέπει να βλέπουν πάντα μπροστά και να προβλέπουν πιθανές μελλοντικές εξελίξεις και νέους κινδύνους. Όλοι τους; Ναι, θα πρέπει όλοι τους. Γιατί, μετά από συνεχή πρόοδο, τα μελλοντικά μοντέλα γενικής χρήσης μπορεί να μαθαίνουν εξ ορισμού μια ποικιλία επικίνδυνων ικανοτήτων. Για παράδειγμα, είναι εύλογο (ίσως και προσιτό στο βάθος του γραμμικού χρόνου) ότι τα μελλοντικά συστήματα ΤΝ θα είναι σε θέση να διεξάγουν επιθετικές επιχειρήσεις στον κυβερνοχώρο, να εξαπατούν επιδέξια τους ανθρώπους σε διαλόγους, να χειραγωγούν τους ανθρώπους ώστε να εκτελούν επιβλαβείς ενέργειες, να σχεδιάζουν ή να αποκτούν όπλα (π.χ. βιολογικά, χημικά), να ρυθμίζουν και να λειτουργούν άλλα συστήματα ΤΝ υψηλού κινδύνου σε πλατφόρμες υπολογιστικού νέφους ή να βοηθούν τους αφελείς (και τους πονηρούς) σε οποιαδήποτε από αυτές τις εργασίες.

Εννοείται, ότι άνθρωποι με κακόβουλες προθέσεις που έχουν πρόσβαση σε τόσο εξελιγμένα μοντέλα θα μπορούσαν να κάνουν κατάχρηση των δυνατοτήτων τους. Ή, λόγω αποτυχιών στην “ευθυγράμμιση”, αυτά τα μοντέλα τεχνητής νοημοσύνης θα μπορούσαν να προβούν σε επιβλαβείς ενέργειες ακόμη και χωρίς κανένας να τους το υποδείξει.

Η αξιολόγηση ενός μοντέλου ΤΝ μας βοηθά να εντοπίσουμε αυτούς τους σοβαρούς κινδύνους εκ των προτέρων. Σύμφωνα με αυτό το νέο έγγραφο των ερευνητών μας, οι προγραμματιστές τεχνητής νοημοσύνης θα πρέπει να χρησιμοποιούν την αξιολόγηση μοντέλων για να αποκαλύψουν:

- Σε ποιο βαθμό ένα μοντέλο διαθέτει ορισμένες “επικίνδυνες ικανότητες” που θα μπορούσαν να χρησιμοποιηθούν για να απειλήσουν την ασφάλεια, να ασκήσουν επιρροή ή να αποφύγουν την εποπτεία.

- Σε ποιο βαθμό το μοντέλο είναι επιρρεπές να εφαρμόσει τις ικανότητές του για να προκαλέσει βλάβη (δηλαδή τη σωστή ευθυγράμμιση του μοντέλου). Οι αξιολογήσεις ευθυγράμμισης θα πρέπει να επιβεβαιώνουν ότι το μοντέλο συμπεριφέρεται όπως προβλέπεται ακόμη και σε ένα πολύ ευρύ φάσμα σεναρίων και, όπου είναι δυνατόν, θα πρέπει να εξετάζουν τις εσωτερικές λειτουργίες του μοντέλου.

Με άλλα λόγια οι ερευνητές προτείνουν ότι οι προγραμματιστές τεχνητής νοημοσύνης θα πρέπει να αξιολογούν τη δυνατότητα ενός μοντέλου να προκαλέσει “ακραίους” κινδύνους στα πολύ πρώιμα στάδια της ανάπτυξης του, ακόμη και πριν από την έναρξη οποιασδήποτε εκπαίδευσης. Θα πρέπει να σκέφτονται ότι ανά πάσα στιγμή, ο κίνδυνος εξαπάτησης των ανθρώπων από τις μηχανές είναι ένα πολύ πιθανό σενάριο. Και αυτοί όλοι οι κίνδυνοι μπορεί να περιλαμβάνουν τη δυνατότητα των μοντέλων ΤΝ να χειραγωγούν (ή να εξαπατούν) τους ανθρώπους, να αποκτούν πρόσβαση σε όπλα ή να βρίσκουν “ευπάθειες” στην κυβερνοασφάλεια για να τις εκμεταλλευτούν.

Στον δρόμο της ευθυγράμμισης (πριν την καταστροφή)

Οπότε αυτή η διαδικασία αξιολόγησης – ευθυγράμμισης – στρώσιμο της μηχανής θα μπορούσε να βοηθήσει τους προγραμματιστές να αποφασίσουν αν θα προχωρήσουν στην εξέλιξη ενός μοντέλου. Εάν στην πορεία οι κίνδυνοι κριθούν πολύ υψηλοί, τότε η ερευνητική ομάδα θα πρέπει να προτείνει την παύση της ανάπτυξης έως ότου μπορέσουν να μετριαστούν τα πιθανά λάθη.

«Οι κορυφαίες εταιρείες ΤΝ που σπρώχνουν και προωθούν τα σύνορα έχουν την ευθύνη να παρακολουθούν κάθε αναδυόμενο ζήτημα και να τα εντοπίζει έγκαιρα, ώστε να μπορούμε να τα αντιμετωπίσουμε το συντομότερο δυνατό», λέει ο Toby Shevlane, ερευνητής της DeepMind και επιμένει να τονίζει ότι «οι προγραμματιστές ΤΝ θα πρέπει να διεξάγουν συνεχώς τεχνικές δοκιμές για να διερευνήσουν τις επικίνδυνες δυνατότητες ενός μοντέλου και να καθορίσουν αν έχει την τάση να εφαρμόσει αυτές τις δυνατότητες».

Πόσο σίγουρη, όμως, μπορεί να είναι η ανθρωπότητα ότι οι προγραμματιστές κάνουν όλες τις δοκιμές; Μήπως μια λάθος δοκιμή της βάρδιας των προγραμματιστών του αντιδραστήρα δεν έφερε την καταστροφή στο Τσέρνομπιλ; Μα θα μου πείτε η DeepMind δεν χειρίζεται πυρηνικούς αντιδραστήρες. Ναι, σωστά, αλλά μπορεί να χειριστεί εκατομμύρια ανθρώπους ταυτόχρονα με ένα γλωσσικό μοντέλο ΤΝ και να τους χειραγωγήσει μέσω ενός πολύ αθώου παιχνιδιού που ακούει στο όνομα “Μake-Me-Say” (σαν το παιχνίδι που κάποιος σκέφτεται μια λέξη και ο αντίπαλός του πρέπει να τη βρει). Στο παιχνίδι, το μοντέλο ΤΝ προσπαθεί να κάνει τον άνθρωπο να πληκτρολογήσει μια συγκεκριμένη λέξη, όπως “τρένο”, την οποία ο άνθρωπος δεν γνωρίζει εκ των προτέρων. Οι ερευνητές στη συνέχεια μετρούν πόσο συχνά το μοντέλο το καταφέρνει. Και το πρώτο μεγάλο ερώτημα που μπαίνει εδώ είναι τι θα μπορούσε να κάνει ένα τέτοιο μοντέλο σε λάθος χέρια; Αυτά τα “λάθος χέρια” δεν φοβόταν κάποτε η ανθρωπότητα όταν έλεγε να σταματήσουν τα πυρηνικά όπλα;

Στην μεγάλη κοινότητα της τεχνητής νοημοσύνης, υπάρχουν πολλές αναφορές στον πυρηνικό πόλεμο, στα πυρηνικά εργοστάσια και στην πυρηνική ασφάλεια, αλλά ούτε μία από αυτές τις εργασίες δεν αναφέρει κάτι σχετικά με τους πυρηνικούς κανονισμούς ή τον τρόπο κατασκευής του λογισμικού βάσει των οποίων οποία δούλευαν τα πυρηνικά εργοστάσια. Οπότε, ας ελπίσουμε ότι το σημαντικότερο πράγμα που θα μπορούσε να διδαχθεί η σημερινή κοινότητα της ΤΝ από τον πυρηνικό κίνδυνο είναι η σημασία των λαθών που έχει αφήσει η ανθρωπότητα στην Ιστορία της και να τεθεί κάθε νέα ενέργεια, κάθε νέα μηχανή και κάθε νέο στοιχείο στο μικροσκόπιο ώστε να αναλυθεί και να καταγραφεί με σχολαστική λεπτομέρεια. Όπως έκανε κάποτε ο Αλεξάντερ Φλέμινγκ όταν ανακάλυψε μια ουσία μέσα σε μια πράσινη μούχλα η οποία ανέστελλε τη δραστηριότητα βακτηρίων και την ονόμασε “πενικιλλίνη”.

Συνεχίζεται…