Μπορεί να έχετε ακούσει για ρομπότ που είναι ικανά να σκοτώνουν, ρομπότ-φονιάδες, ή τα ρομπότ-εξολοθρευτές – που επίσημα ονομάζονται αυτόνομα φονικά όπλα (LAW) – από ταινίες και βιβλία. Και η ιδέα των έξυπνων όπλων που θα αλωνίζουν εξακολουθεί να βρίσκεται στη σφαίρα της επιστημονικής φαντασίας. Εξοπλισμένα με τεχνητή νοημοσύνη, μερικά από αυτά τα όπλα θα μπορούσαν, χωρίς άμεσο ανθρώπινο έλεγχο, να επιλέξουν μόνα τους και να εξαλείψουν τους στόχους με ταχύτητα και αποτελεσματικότητα που οι στρατιώτες δεν μπορούν καν να φανταστούν. Η έλευσή τους θεωρείται η «3η επανάσταση» στον πόλεμο από τους ειδικούς μετά την εφεύρεση της πυρίτιδας και των πυρηνικών όπλων. Καθώς όμως τα όπλα τεχνητής νοημοσύνης εξελίσσονται όλο και περισσότερο, η ανησυχία του κοινού αυξάνεται λόγω των εύλογων φόβων για την έλλειψη λογοδοσίας και τον κίνδυνο τεχνικής αποτυχίας. Η εμφάνιση των αυτόνομων έξυπνων όπλων έχει κάνει δικαιολογημένα πολλούς αναλυτές να τρέμουν.

Ήδη έχουμε δει πώς η λεγόμενη ουδέτερη τεχνητή νοημοσύνη δημιούργησε σεξιστικούς αλγορίθμους και ακατάλληλα συστήματα, κυρίως επειδή οι δημιουργοί τους δεν κατανοούσαν την τεχνολογία. Αλλά στον πόλεμο, αυτού του είδους οι αστοχίες θα μπορούσαν να σκοτώσουν αμάχους ή να διαλύσουν τις πολιτικές διαπραγματεύσεις.

Για παράδειγμα, ένας αλγόριθμος αναγνώρισης στόχων θα μπορούσε να εκπαιδευτεί να αναγνωρίζει τανκς από δορυφορικές εικόνες.Τι γίνεται όμως αν όλες οι εικόνες που χρησιμοποιούνται για την εκπαίδευση του συστήματος εμφανίζουν στρατιώτες σε σχηματισμό γύρω από το άρμα; Μπορεί να μπερδέψει ένα πολιτικό όχημα που περνάει μέσα από στρατιωτικό αποκλεισμό με στόχο.

Γιατί χρειαζόμαστε φονικά όπλα;

Οι άμαχοι σε πολλές χώρες (όπως το Βιετνάμ, το Αφγανιστάν και η Υεμένη) έχουν υποφέρει εξαιτίας του τρόπου με τον οποίο οι παγκόσμιες υπερδυνάμεις κατασκευάζουν και χρησιμοποιούν ολοένα και πιο προηγμένα όπλα. Πολλοί άνθρωποι θα υποστήριζαν ότι έχουν κάνει περισσότερο κακό παρά καλό, με πιο πρόσφατη επισήμανση τη ρωσική εισβολή στην Ουκρανία στις αρχές του 2022.

Στο άλλο στρατόπεδο βρίσκονται αυτοί που λένε ότι μια χώρα πρέπει να είναι σε θέση να υπερασπιστεί τον εαυτό της, πράγμα που σημαίνει ότι πρέπει να συμβαδίζει με τη στρατιωτική τεχνολογία άλλων εθνών. Η τεχνητή νοημοσύνη μπορεί ήδη να ξεπεράσει τους ανθρώπους στο σκάκι και το πόκερ. Ξεπερνά τους ανθρώπους και στον πραγματικό κόσμο. Για παράδειγμα, η Microsoft ισχυρίζεται ότι το λογισμικό αναγνώρισης ομιλίας της έχει ποσοστό σφάλματος 1% σε σύγκριση με το ανθρώπινο ποσοστό σφάλματος που είναι περίπου 6%. Έτσι, δεν αποτελεί έκπληξη το γεγονός ότι οι στρατοί παραδίδουν σιγά-σιγά τα ηνία στους αλγόριθμους.

Πώς όμως θα αποφύγουμε να προσθέσουμε τα ρομπότ-φονιάδες στον μακρύ κατάλογο των πραγμάτων που θα ευχόμασταν να μην είχαμε εφεύρει ποτέ;

Κανόνας πρώτος: γνωρίζεις τον εχθρό σου.

Τι είναι τα θανατηφόρα αυτόνομα όπλα (LAW);

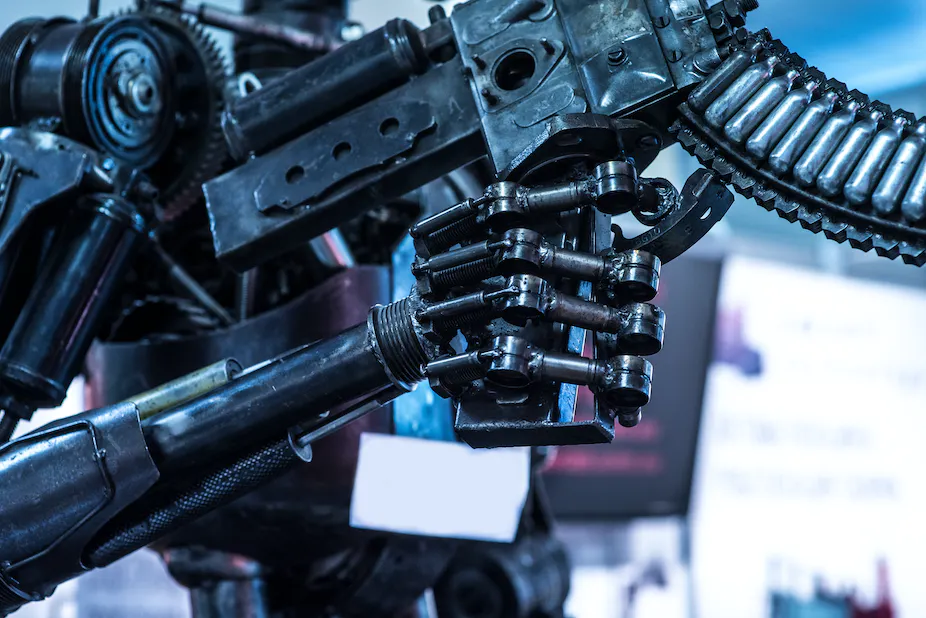

Το Υπουργείο Άμυνας των ΗΠΑ ορίζει ένα αυτόνομο οπλικό σύστημα ως εξής: «Ένα οπλικό σύστημα που, μόλις ενεργοποιηθεί, μπορεί να επιλέξει και να προσβάλει στόχους χωρίς περαιτέρω παρέμβαση από ανθρώπινο χειριστή».

Πολλά συστήματα μάχης πληρούν ήδη αυτό το κριτήριο. Οι υπολογιστές των drones αεροσκαφών και των σύγχρονων πυραύλων διαθέτουν αλγόριθμους που μπορούν να εντοπίζουν στόχους και να τους βάλλουν με πολύ μεγαλύτερη ακρίβεια από ό,τι ένας ανθρώπινος χειριστής. Το Iron Dome του Ισραήλ είναι ένα από τα πολλά ενεργά αμυντικά συστήματα που μπορούν να πλήξουν στόχους χωρίς ανθρώπινη επίβλεψη.

Αν και έχει σχεδιαστεί για την αντιπυραυλική άμυνα, το Iron Dome θα μπορούσε να σκοτώσει ανθρώπους κατά λάθος. Αλλά ο κίνδυνος θεωρείται αποδεκτός στη διεθνή πολιτική, επειδή Ο «Σιδηρούς Θόλος», το υπερόπλο του Ισραήλ έχει γενικά ένα αξιόπιστο ιστορικό προστασίας της ζωής των πολιτών.

Υπάρχουν επίσης όπλα με δυνατότητα Τεχνητής Νοημοσύνης που έχουν σχεδιαστεί για να επιτίθενται σε ανθρώπους, από ρομπότ-φρουρούς μέχρι τα αεροσκάφη drones-καμικάζι που χρησιμοποιήθηκαν στον πόλεμο της Ουκρανίας. Τα LAW είναι ήδη εδώ. Έτσι, αν θέλουμε να επηρεάσουμε τη χρήση τους, θα πρέπει αρχικά να κατανοήσουμε την ιστορία των σύγχρονων όπλων.

Οι κανόνες του πολέμου

Οι διεθνείς συμφωνίες, όπως οι Συμβάσεις της Γενεύης, καθορίζουν τους όρους για τη μεταχείριση των αιχμαλώτων πολέμου και των αμάχων κατά τη διάρκεια των συγκρούσεων. Είναι ένα από τα λίγα μέσα που έχουμε για να ελέγχουμε τον τρόπο διεξαγωγής των πολέμων. Δυστυχώς, η χρήση χημικών όπλων από τις ΗΠΑ κατά του Βιετνάμ και από τη Ρωσία κατά του Αφγανιστάν αποδεικνύουν ότι τα μέτρα αυτά δεν είναι πάντα επιτυχή.

Το χειρότερο είναι όταν οι βασικοί εμπλεκόμενοι αρνούνται να υπογράψουν. Η Διεθνής Εκστρατεία για την Απαγόρευση των Ναρκών (ICBL) ασκεί πιέσεις στους πολιτικούς από το 1992 για την απαγόρευση των ναρκών και των πυρομαχικών διασποράς (που διασκορπίζουν τυχαία μικρές βόμβες σε μεγάλη έκταση). Το 1997 η συνθήκη της Οτάβα περιελάβανε την απαγόρευση αυτών των όπλων, την οποία υπέγραψαν 122 χώρες. Όμως οι ΗΠΑ, η Κίνα και η Ρωσία δεν προσχώρησαν.

Οι νάρκες έχουν τραυματίσει και σκοτώσει τουλάχιστον 5.000 στρατιώτες και πολίτες ετησίως από το 2015 και μέχρι 9.440 άτομα από το 2017 μέχρι σήμερα. Η έκθεση Landmine and Cluster Munition Monitor 2022 αναφέρει:

Οι απώλειες… είναι ανησυχητικά υψηλές τα τελευταία επτά χρόνια, μετά από μια δεκαετία ιστορικών μειώσεων. Το έτος 2021 δεν αποτέλεσε εξαίρεση. Η τάση αυτή είναι σε μεγάλο βαθμό αποτέλεσμα των αυξημένων συγκρούσεων και της μόλυνσης από αυτοσχέδιες νάρκες που παρατηρούνται από το 2015. Οι άμαχοι αντιπροσώπευαν τα περισσότερα από τα καταγεγραμμένα θύματα, τα μισά από τα οποία ήταν παιδιά.

Παρά τις προσπάθειες της ICBL, υπάρχουν ενδείξεις ότι τόσο η Ρωσία όσο και η Ουκρανία (μέλος της συνθήκης της Οτάβα) χρησιμοποιούν νάρκες κατά τη διάρκεια της ρωσικής εισβολής στην Ουκρανία. Η Ουκρανία έχει επίσης στηριχθεί σε drones για την καθοδήγηση των επιθέσεων πυροβολικού ή πιο πρόσφατα για «επιθέσεις καμικάζι» σε ρωσικές υποδομές.

Το μέλλον μας

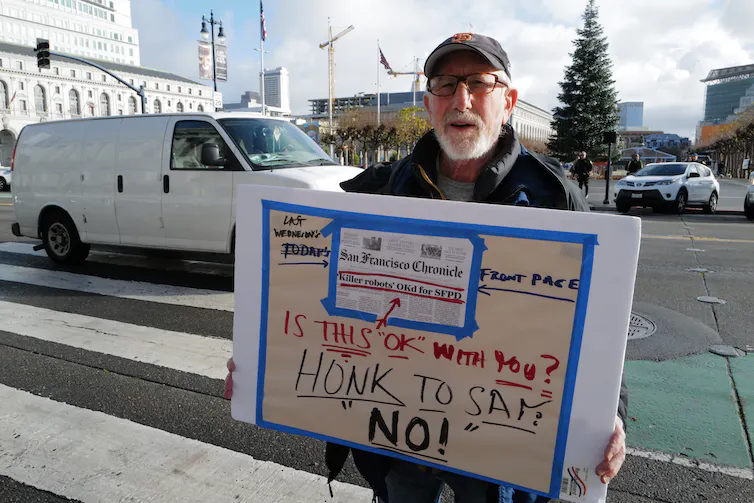

Αλλά τι γίνεται με τα πιο προηγμένα όπλα με τεχνητή νοημοσύνη; Η Εκστρατεία για να απαγορευτοούν τα ρομπότ δολοφόνων απαριθμεί εννέα βασικά προβλήματα με τα LAW, εστιάζοντας στην έλλειψη λογοδοσίας και στον εγγενή απανθρωπισμό των δολοφονιών που τα συνοδεύει.

Ενώ η κριτική αυτή είναι βάσιμη, η πλήρης απαγόρευση των LAW είναι μη ρεαλιστική για δύο λόγους. Πρώτον, όπως και με τις νάρκες, το κουτί της Πανδώρας έχει ήδη ανοίξει. Επίσης, τα όρια μεταξύ των αυτόνομων όπλων, LAW και των δολοφονικών ρομπότ είναι τόσο θολά που είναι δύσκολο να γίνει διάκριση μεταξύ τους. Οι στρατιωτικοί ηγέτες θα είναι πάντα σε θέση να βρουν ένα παραθυράκι στη διατύπωση μιας απαγόρευσης και να βάλουν κρυφά ρομπότ δολοφόνων σε υπηρεσία ως αμυντικά αυτόνομα όπλα. Ίσως γίνει ακόμη και εν αγνοία τους.

Είναι σχεδόν βέβαιο ότι στο μέλλον θα δούμε πολλά περισσότερα όπλα με δυνατότητες τεχνητής νοημοσύνης. Αλλά αυτό δεν σημαίνει ότι πρέπει να κάνουμε τα στραβά μάτια. Πιο συγκεκριμένες και διαφοροποιημένες απαγορεύσεις θα βοηθούσαν ώστε να κρατήσουμε τους πολιτικούς, τους επιστήμονες και τους μηχανικούς υπόλογους σε μια πανανθρώπινη ηθική.

Για παράδειγμα, με την απαγόρευση:

– black box AI: συστήματα όπου ο χρήστης δεν έχει καμία πληροφορία για τον αλγόριθμο πέραν των εισροών και των εκροών.

– αναξιόπιστη τεχνητή νοημοσύνη: συστήματα που έχουν δοκιμαστεί ανεπαρκώς (όπως στο παράδειγμα του στρατιωτικού αποκλεισμού που αναφέρθηκε προηγουμένως).

Και δεν χρειάζεται να είστε ειδικός στην Τεχνητή Νοημοσύνη για να γνωρίζετε για τα αυτόνομα φονικά όπλα LAW. Μείνετε ενήμεροι για τις νέες εξελίξεις της στρατιωτικής Τεχνητής Νοημοσύνης. Όταν διαβάζετε ή ακούτε για την Τεχνητή Νοημοσύνη που χρησιμοποιείται στη μάχη, αναρωτηθείτε: είναι δικαιολογημένη; Προστατεύει τη ζωή των πολιτών και των αμάχων; Η εξουσιοδότηση για να σκοτώσει μια μηχανή δεν είναι δικαιολογημένη και αποτελεί παραβίαση των ανθρωπίνων δικαιωμάτων επειδή οι μηχανές δεν είναι ηθικοί παράγοντες και έτσι δεν είναι υπεύθυνες για τη λήψη αποφάσεων ζωής και θανάτου.

Τα όπλα προορίζονται όλο και περισσότερο να είναι «έξυπνα» και έτσι θα συνεχίσουν να κινούνται προς αυτή την κατεύθυνση. Οι κυβερνήσεις έχουν την ευθύνη να διασφαλίσουν ότι υπάρχουν κανονισμοί και τα κράτη να θέσουν σε εφαρμογή το τι είναι πρόθυμα να δεχθούν και τι δεν είναι. Μέχρι σήμερα, 28 κράτη έχουν ζητήσει την πλήρη απαγόρευση των αυτόνομων θανατηφόρων όπλων. Παρόλο που οι συνομιλίες του ΟΗΕ διεξάγονται ήδη από το 2014, η επικείμενη απειλή απαιτεί μια πολύ πιο αποτελεσματική και γρήγορη διαδικασία. Αυτή η διπλωματική διαδικασία είναι αργή και ενώ βλέπουμε ότι όλο και αυξάνονται οι φωνές κρατών και ανθρώπων που βλέπουν την ανάγκη θέσπισης σαφών διεθνών κανόνων δεν κινούμαστε αρκετά γρήγορα.