Η τεχνητή νοημοσύνη (AI) και η προστασία δεδομένων είναι δύο σημαντικά πεδία που διασταυρώνονται όλο και περισσότερο μεταξύ τους. Καθώς η τεχνολογία AI συνεχίζει να προοδεύει, εγείρει σημαντικά ηθικά ερωτήματα σχετικά με τη χρήση προσωπικών δεδομένων.

Στον αγώνα για να κάνουν κάθε νέο μοντέλο AI καλύτερο από το προηγούμενο, υπάρχει η τάση οι εταιρείες καταφεύγουν σε ανήθικες τεχνικές συλλογής δεδομένων για να προηγηθούν στον ανταγωνισμό.

Η τεχνολογική αυτή καινοτομία χρησιμοποιεί τεράστιες ποσότητες δεδομένων και ορισμένα από αυτά θα μπορούσαν να είναι ευαίσθητες προσωπικές πληροφορίες. Τα ιδιωτικά μας δεδομένα, συμπεριλαμβανομένων των ιατρικών αρχείων, φωτογραφιών, περιεχομένου μέσων κοινωνικής δικτύωσης κ.λπ., μπαίνουν όλα σε σύνολα δεδομένων για εκπαίδευση μοντέλων τεχνητής νοημοσύνης.

Γεγονός που εγείρει το νομικό και ηθικό ερώτημα σχετικά με τον τρόπο δημιουργίας και διατήρησης του απορρήτου των χρηστών, ενώ εξακολουθεί να λαμβάνει και να επεξεργάζεται τα δεδομένα που χρειάζονται οι εταιρείες για να τροφοδοτήσουν τη χρήση της τεχνητής νοημοσύνης.

Τα δεδομένα σας κλέβονται

Το σπίτι είναι ο ασφαλής μας χώρος, αλλά τι συμβαίνει όταν οι συσκευές μας αρχίζουν να διαρρέουν τα δεδομένα μας; Ο Kashmir Hill και η Surya Mattu, δημοσιογράφοι ερευνητικών δεδομένων, αποκάλυψαν πώς οι έξυπνες συσκευές στα σπίτια μας κάνουν ακριβώς αυτό. Στην αρχή, μπορεί να ακούγεται σαν σενάριο επιστημονικής φαντασίας ότι η ηλεκτρική οδοντόβουρτσά σας στέλνει τακτικά δεδομένα στη μητρική της εταιρεία.

Ωστόσο, αποκαλύπτουν στην ομιλία τους στο TED του 2018 πώς μερικά από αυτά τα δεδομένα που συλλέγονται μπορούν να μας στοιχειώσουν. Για παράδειγμα, ο πάροχος οδοντιατρικής ασφάλισης μπορεί να αγοράσει τα δεδομένα σας από την εταιρεία οδοντόβουρτσας και να χρεώσει υψηλότερο ασφάλιστρο εάν παραλείψετε να βουρτσίζετε τα δόντια σας το βράδυ.

Το 2020, μια φωτογραφία μιας γυναίκας που κάθεται σε μια τουαλέτα διέρρευσε στο διαδίκτυο, η οποία πυροδότησε τεράστια διαμάχη. Η ρομποτική ηλεκτρική σκούπα Roomba J7 τράβηξε αυτή τη φωτογραφία ως μέρος της συνήθους συλλογής δεδομένων της. Αυτή ήταν μόνο μία από μια σειρά φωτογραφιών που απαθανάτιζαν ολόκληρα νοικοκυριά, αντικείμενα και τους ανθρώπους που ζούσαν σε αυτά

Τα σύνολα δεδομένων που χρησιμοποιούνται για την κατάρτιση της τεχνολογίας AI για σύνθεση εικόνας δημιουργούνται με συλλογή εικόνων από το Διαδίκτυο, των οποίων οι κάτοχοι πνευματικών δικαιωμάτων και τα υποκείμενα μπορεί να έχουν δώσει ή όχι την άδειά τους για χρήση (να σημειωθεί ότι η ανάγνωση όλων των πολιτικών απορρήτου που συναντάτε σε ένα χρόνο από μεγάλες εταιρείες τεχνολογίας θα χρειαζόταν 30 ολόκληρες εργάσιμες ημέρες από τη ζωή σας).

Ακόμη και τα ιδιωτικά ιατρικά αρχεία ασθενών καταλήγουν ως δεδομένα εκπαίδευσης για μοντέλα AI. Η Lapine, μια καλλιτέχνις από την Καλιφόρνια, ανακάλυψε ότι οι φωτογραφίες του ιατρικού της φακέλου που τράβηξε ο γιατρός της το 2013 συμπεριλήφθηκαν στο σύνολο εικόνων LAION-5B, ένα σύνολο δεδομένων που χρησιμοποιείται από το Stable Diffusion και το Google Imagen.

Το ανακάλυψε μέσω του εργαλείου: Have I Been Trained, ένα έργο της καλλιτέχνιδας Holly Herndon που επιτρέπει σε οποιονδήποτε να ελέγξει εάν οι φωτογραφίες του έχουν χρησιμοποιηθεί για την εκπαίδευση μοντέλων AI.

Το σύνολο δεδομένων LAION-5B, το οποίο έχει περισσότερες από 5 δισεκατομμύρια εικόνες, περιλαμβάνει πορνό διασημοτήτων με photoshop, χακαρισμένο και κλεμμένο μη συναινετικό πορνό και γραφικές εικόνες αποκεφαλισμών του ISIS. Περιλαμβάνουν έργα τέχνης ζωντανών καλλιτεχνών, φωτογραφίες φωτογράφων, ιατρικές εικόνες και φωτογραφίες ανθρώπων που πιθανώς δεν πίστευαν ότι οι εικόνες τους θα κατέληγαν ξαφνικά ως βάση για να εκπαιδεύσουμε ένα σύστημα τεχνητής νοημοσύνης.

Διακυβευμένες ταυτότητες

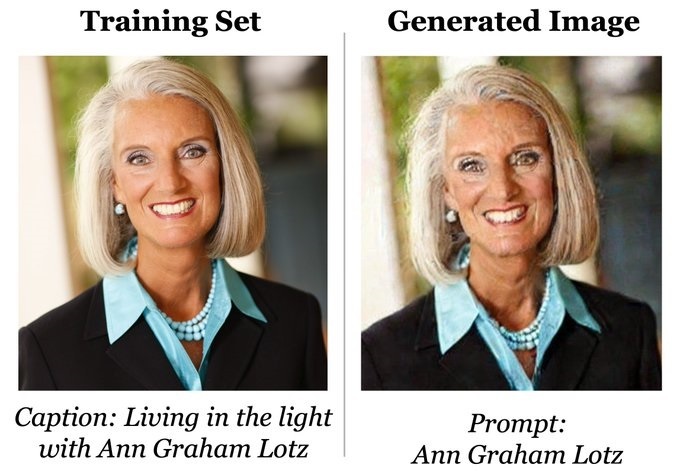

Έρευνες αποδεικνύουν ότι τα πρόσωπα που παραγονται από τεχνολογία ΑΙ μπορούν μέσω της αντίστροφης μηχανικής να εκθέσουν τους πραγματικούς ανθρώπους που το ενέπνευσαν

Τα πρόσωπα που δημιουργούνται από AI είναι πλέον mainstream. Οι σχεδιαστές τα χρησιμοποιούν ως μοντέλα για τις λήψεις των προϊόντων τους ή ως ψεύτικα πρόσωπα. Η ιδέα ήταν ότι εφόσον δεν ήταν αληθινά άτομα, δεν θα χρειάζονταν συγκατάθεση. Ωστόσο, αυτά τα δημιουργημένα πρόσωπα δεν είναι τόσο μοναδικά όσο φαίνονται.

Το 2021, οι ερευνητές μπόρεσαν να πάρουν ένα πρόσωπο που δημιουργήθηκε από τεχνολογία ΑΙ και να το επαναφέρουν στα αρχικά ανθρώπινα πρόσωπα από το σύνολο δεδομένων που το ενέπνευσε. Τα πρόσωπα που δημιουργούνται μοιάζουν με τα αρχικά με μικρές αλλαγές, εκθέτοντας έτσι τις πραγματικές ταυτότητες των ατόμων σε αυτά τα σύνολα δεδομένων.

Σε αντίθεση με τα πρόσωπα που παραγονται από τεχνολογία ΑΙ , τα οποία παράγουν εικόνες που μοιάζουν πολύ με τα δείγματα εκπαίδευσης, τα μοντέλα διάχυσης (DALL-E ή Midjourney) πιστεύεται ότι παράγουν πιο ρεαλιστικές εικόνες που διαφέρουν σημαντικά από εκείνες στο σετ εκπαίδευσης. Δημιουργώντας πρωτότυπες εικόνες, προσέφεραν έναν τρόπο διατήρησης του απορρήτου των ατόμων στο σύνολο δεδομένων.

Ωστόσο, μια εργασία με τίτλο Εξαγωγή δεδομένων εκπαίδευσης από μοντέλα διάχυσης δείχνει πώς τα μοντέλα διάχυσης απομνημονεύουν μεμονωμένες εικόνες από τα δεδομένα προπόνησής τους και τις αναγεννούν κατά τη διάρκεια εκτέλεσης. Η δημοφιλής ιδέα για το πώς τα μοντέλα τεχνητής νοημοσύνης είναι «μαύρα κουτιά» που δεν αποκαλύπτουν τίποτα μέσα επανεξετάζεται μέσω αυτών των πειραμάτων.

Υπερφόρτιση της κοινωνίας επιτήρησης με AI

Ενώ τα συστήματα επιτήρησης που βασίζονται στην τεχνητή νοημοσύνη μπορεί να φαίνονται πολύτιμο εργαλείο για την καταπολέμηση του εγκλήματος και της τρομοκρατίας, εγείρουν ανησυχίες για το απόρρητο και τις πολιτικές ελευθερίες και τη δημιοουργία ενός παγκοσμιοποιημένου Big Brother που θα ελέγχει κάθε μας κίνηση.

Μία από τις πιο αμφιλεγόμενες περιπτώσεις έξυπνης παρακολούθησης σημειώθηκε κατά τη διάρκεια των διαδηλώσεων στο Χονγκ Κονγκ το 2019. Η αστυνομία χρησιμοποίησε τεχνολογία αναγνώρισης προσώπου για να αναγνωρίσει τους διαδηλωτές και να τους τιμωρήσει μεμονωμένα. Οι διαδηλωτές το συνειδητοποίησαν αυτό και στόχευσαν τους χακαρισμένους δείκτες λέιζερ τους στις κάμερες για να κάψουν τους αισθητήρες εικόνας τους.

Η κινεζική κυβέρνηση έχει χρησιμοποιήσει την τεχνητή νοημοσύνη σε ευρείας κλίμακας καταστολές σε περιοχές που φιλοξενούν εθνοτικές μειονότητες εντός της Κίνας. Τα συστήματα επιτήρησης στο Θιβέτ αλλά και στην επαρχία Xinjiang, έχουν περιγραφεί ως «οργουελικά». Αυτές οι προσπάθειες περιλαμβάνουν υποχρεωτικά δείγματα DNA, παρακολούθηση δικτύου Wi-Fi και εκτεταμένες κάμερες αναγνώρισης προσώπου, όλες συνδεδεμένες με ολοκληρωμένες πλατφόρμες ανάλυσης δεδομένων.

Πολιτικές και πλαίσια

- Η Ομοσπονδιακή Επιτροπή Εμπορίου των ΗΠΑ (FTC) έχει μια προκλητική απάντηση σε AI που παραβιάζουν το απόρρητο. Απαιτούν από τις εταιρείες και τους οργανισμούς να καταστρέψουν τους αλγόριθμους ή τα μοντέλα τεχνητής νοημοσύνης που έχουν κατασκευάσει χρησιμοποιώντας προσωπικές πληροφορίες και δεδομένα που συλλέγονται κακοπροαίρετα ή παράνομα.

- Το Ευρωπαϊκό Κοινοβούλιο έχει κάνει ένα σημαντικό βήμα προς την προστασία του ιδιωτικού απορρήτου στην εποχή της τεχνητής νοημοσύνης. Υποστήριξαν την πρόταση για απαγόρευση της επιτήρησης τεχνητής νοημοσύνης σε δημόσιους χώρους. Ο ευρέως δημοφιλής Γενικός Κανονισμός Προστασίας Δεδομένων (GDPR) της ΕΕ διαθέτει επίσης το καλύτερο πλαίσιο προστασίας δεδομένων, το οποίο απαιτεί τη συναίνεση των ατόμων πριν από τη συλλογή και χρήση των δεδομένων τους.

- Ο νόμος του Καναδά για την προστασία των προσωπικών πληροφοριών και τα ηλεκτρονικά έγγραφα (PIPEDA) απαιτεί από τις επιχειρήσεις να τηρούν «εύλογες» δικλείδες ασφαλείας για την προστασία των προσωπικών πληροφοριών. Και στις ΗΠΑ, ο νόμος περί απορρήτου των καταναλωτών της Καλιφόρνια (CCPA) είναι ένας ολοκληρωμένος νόμος περί απορρήτου που παρέχει στα άτομα το δικαίωμα να ρωτούν ποιες προσωπικές πληροφορίες έχουν συλλέξει οι οργανισμοί, πώς χρησιμοποιούνται και για ποιο σκοπό.

Προγράμματα που αντιστέκονται στην διάχυση δεδομένων

- Have I Been Trained: Μια πλατφόρμα που διευκολύνει την αναζήτηση αν τα δεδομένα μας έχουν χρησιμοποιηθεί ή όχι για την εκπαίδευση της τεχνητής νοημοσύνης. Μπορείτε να ανεβάσετε τις φωτογραφίες σας για να ελέγξετε αν έχουν μπει στα σύνολα δεδομένων των μοντέλων διάχυσης. Αυτό είναι μέρος ενός μεγαλύτερου έργου που ονομάζεται Spawning.ai, το οποίο επιτρέπει στους ανθρώπους να ανακτήσουν τον έλεγχο των δεδομένων τους. Αναπτύσσουν επίσης εργαλεία εξαίρεσης και συμμετοχής που σας δίνουν τη δυνατότητα να αποφασίσετε εάν τα δεδομένα σας θα χρησιμοποιηθούν για εκπαίδευση.

- Microsoft Synthetic Faces: Ένα σύνολο 100.000 συνθετικών προσώπων από τη Microsoft που μπορούν να χρησιμοποιηθούν για την εκπαίδευση αλγορίθμων αναγνώρισης προσώπου χωρίς τη χρήση πραγματικών ανθρώπων.

- AI Camouflage: Αντίπαλα μπαλώματα που μπορούν να ενσωματωθούν σε ρούχα και άλλα αντικείμενα που προκαλούν σύγχυση στα συστήματα ταξινόμησης της τεχνητής νοημοσύνης.

- Adversarial Makeup: Μακιγιάζ προσώπου που μπερδεύει τα συστήματα ταξινόμησης AI και σας κάνει αόρατους. Το CV dazzle προσφέρει επίσης μαθήματα μακιγιάζ στο Youtube:

- Alias:: Μια παρέμβαση απορρήτου από τον Bjørn Karmann που εμποδίζει τους βοηθούς φωνής να σας ακούν συνεχώς.

Στο βιβλίο του New Dark Age, ο James Bridle κάνει ένα σχόλιο σχετικά με το πώς η επιτήρηση της τεχνητής νοημοσύνης μετατρέπει την κλινική παράνοια σε πραγματικότητα.

Ένα από τα πρώτα συμπτώματα κλινικής παράνοιας είναι η πεποίθηση ότι κάποιος σε παρακολουθεί. αλλά αυτή η πεποίθηση είναι πλέον λογική. Κάθε email που στέλνουμε, κάθε μήνυμα κειμένου που γράφουμε, κάθε τηλεφώνημα που κάνουμε, κάθε ταξίδι που κάνουμε, κάθε βήμα, ανάσα, όνειρο και εκφώνηση είναι ο στόχος τεράστιων συστημάτων αυτοματοποιημένης συλλογής πληροφοριών, των αλγορίθμων ταξινόμησης των κοινωνικών δικτύων και των εργοστασίων ανεπιθύμητης αλληλογραφίας και του άγρυπνου βλέμματος των δικών μας smartphone και συνδεδεμένων συσκευών. Ποιος είναι λοιπόν παρανοϊκός τώρα;